Что общего у Wine и WSL. Анализ механизмов выполнения приложений

Wine (Wine Is Not an Emulator) и WSL (Windows Subsystem for Linux) являются двумя различными технологиями, которые позволяют пользователям запускать приложения, созданные для других операционных систем, на компьютерах под управлением Windows. Хотя они имеют разные цели и механизмы работы, между ними есть некоторые общие черты, которые стоит рассмотреть.

Основная цель Wine — позволить пользователям запускать приложения, созданные для операционной системы Linux, на компьютерах под управлением Windows без необходимости эмуляции всей операционной системы. Вместо этого Wine предоставляет прослойку, которая позволяет приложениям Linux работать так, как если бы они были запущены в среде Windows. Это достигается путём перехвата вызовов API Windows и преобразования их в вызовы POSIX, которые могут быть поняты приложением Linux.

WSL, с другой стороны, представляет собой более глубокую интеграцию Linux в Windows. Вместо того чтобы просто предоставлять прослойку для запуска приложений Linux, WSL полностью интегрирует ядро Linux в Windows, позволяя пользователям запускать полноценную операционную систему Linux внутри Windows. Это означает, что пользователи могут использовать все преимущества Linux, такие как работа с командной строкой, управление процессами и установка пакетов через менеджер пакетов APT или YUM.

Несмотря на различия в механизмах работы, обе технологии имеют общую черту: они позволяют пользователям запускать приложения, созданные для других операционных систем, на компьютерах под управлением Windows. Это делает их ценными инструментами для разработчиков и пользователей, которым необходимо работать с приложениями, созданными для разных платформ.

Кроме того, обе технологии предоставляют возможность использования инструментов разработки и отладки, специфичных для каждой операционной системы. Например, разработчики могут использовать инструменты разработки и отладки, такие как Visual Studio Code, для создания и тестирования приложений для Linux прямо на своих компьютерах под управлением Windows.

— Native, который включает в себя портированные библиотеки Windows API, написанные на C.

— Windows API, который имитирует поведение Windows API для приложений Windows.

Программы Windows используют API для взаимодействия с операционной системой. Приложения Windows вызывают функции Windows API, которые затем взаимодействуют с аппаратным обеспечением компьютера. Когда приложение Windows запускается в Wine, оно вызывает функции Windows API, которые затем интерпретируются Wine как соответствующие функции Unix.

Приложение Windows может взаимодействовать с аппаратным обеспечением компьютера с помощью драйверов устройств Windows. Однако при запуске в Wine эти драйверы не используются, вместо них применяются драйверы устройств Unix.

Для работы с файлами и папками приложения Windows используют API Windows. В Wine эти API интерпретируются как соответствующие Unix API. Таким образом, когда приложение Windows пытается получить доступ к файлу или папке, Wine использует Unix API для доступа к этим файлам и папкам.

Для графического интерфейса приложения Windows используют API Windows. В Wine эти API интерпретируются как соответствующие X Window System API. Таким образом, когда приложение Windows пытается отобразить окно на экране, Wine использует X Window System для отображения окна.

Wine также поддерживает DirectX, что позволяет запускать игры и другие приложения, использующие эту технологию.

— Ядро Linux, которое является основой любой операционной системы Linux. Оно отвечает за взаимодействие с аппаратными средствами компьютера и выполнение большинства операций системы.

— Пользовательское пространство Linux, которое включает в себя все программы и утилиты, необходимые для работы в Linux. Это пространство включает в себя командную оболочку, файловую систему, сетевые утилиты и многое другое.

— Уровень совместимости, который преобразует вызовы API Windows в вызовы API Linux. Это позволяет приложениям Windows взаимодействовать с WSL без необходимости изменения кода.

Когда приложение Windows запускается в WSL, оно сначала проходит через уровень совместимости, который преобразует вызовы API Windows в вызовы API Linux. Затем приложение передаётся в пользовательское пространство Linux, где оно выполняется как обычное приложение Linux.

WSL также поддерживает установку дополнительных пакетов через менеджер пакетов APT или YUM, что позволяет расширять функциональность системы.

Основная цель Wine — позволить пользователям запускать приложения, созданные для операционной системы Linux, на компьютерах под управлением Windows без необходимости эмуляции всей операционной системы. Вместо этого Wine предоставляет прослойку, которая позволяет приложениям Linux работать так, как если бы они были запущены в среде Windows. Это достигается путём перехвата вызовов API Windows и преобразования их в вызовы POSIX, которые могут быть поняты приложением Linux.

WSL, с другой стороны, представляет собой более глубокую интеграцию Linux в Windows. Вместо того чтобы просто предоставлять прослойку для запуска приложений Linux, WSL полностью интегрирует ядро Linux в Windows, позволяя пользователям запускать полноценную операционную систему Linux внутри Windows. Это означает, что пользователи могут использовать все преимущества Linux, такие как работа с командной строкой, управление процессами и установка пакетов через менеджер пакетов APT или YUM.

Несмотря на различия в механизмах работы, обе технологии имеют общую черту: они позволяют пользователям запускать приложения, созданные для других операционных систем, на компьютерах под управлением Windows. Это делает их ценными инструментами для разработчиков и пользователей, которым необходимо работать с приложениями, созданными для разных платформ.

Кроме того, обе технологии предоставляют возможность использования инструментов разработки и отладки, специфичных для каждой операционной системы. Например, разработчики могут использовать инструменты разработки и отладки, такие как Visual Studio Code, для создания и тестирования приложений для Linux прямо на своих компьютерах под управлением Windows.

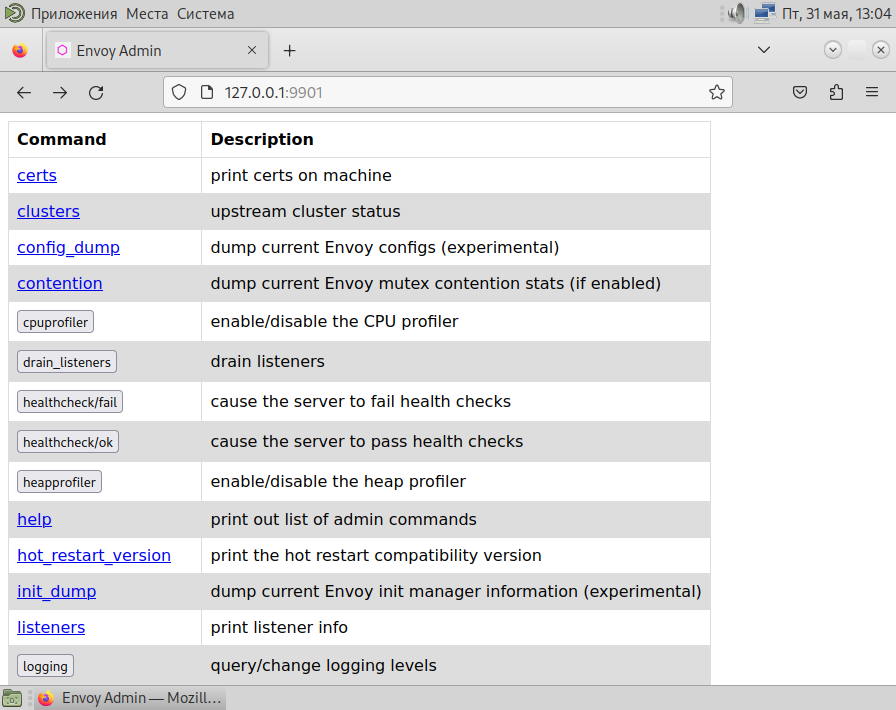

Анализ работы Wine

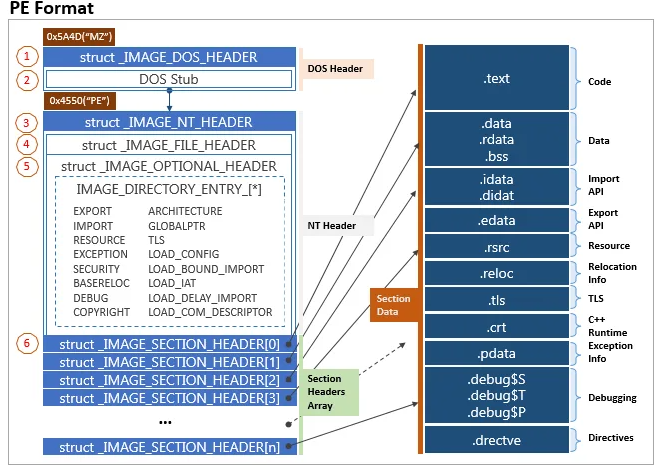

Wine состоит из двух основных компонентов:— Native, который включает в себя портированные библиотеки Windows API, написанные на C.

— Windows API, который имитирует поведение Windows API для приложений Windows.

Программы Windows используют API для взаимодействия с операционной системой. Приложения Windows вызывают функции Windows API, которые затем взаимодействуют с аппаратным обеспечением компьютера. Когда приложение Windows запускается в Wine, оно вызывает функции Windows API, которые затем интерпретируются Wine как соответствующие функции Unix.

Приложение Windows может взаимодействовать с аппаратным обеспечением компьютера с помощью драйверов устройств Windows. Однако при запуске в Wine эти драйверы не используются, вместо них применяются драйверы устройств Unix.

Для работы с файлами и папками приложения Windows используют API Windows. В Wine эти API интерпретируются как соответствующие Unix API. Таким образом, когда приложение Windows пытается получить доступ к файлу или папке, Wine использует Unix API для доступа к этим файлам и папкам.

Для графического интерфейса приложения Windows используют API Windows. В Wine эти API интерпретируются как соответствующие X Window System API. Таким образом, когда приложение Windows пытается отобразить окно на экране, Wine использует X Window System для отображения окна.

Wine также поддерживает DirectX, что позволяет запускать игры и другие приложения, использующие эту технологию.

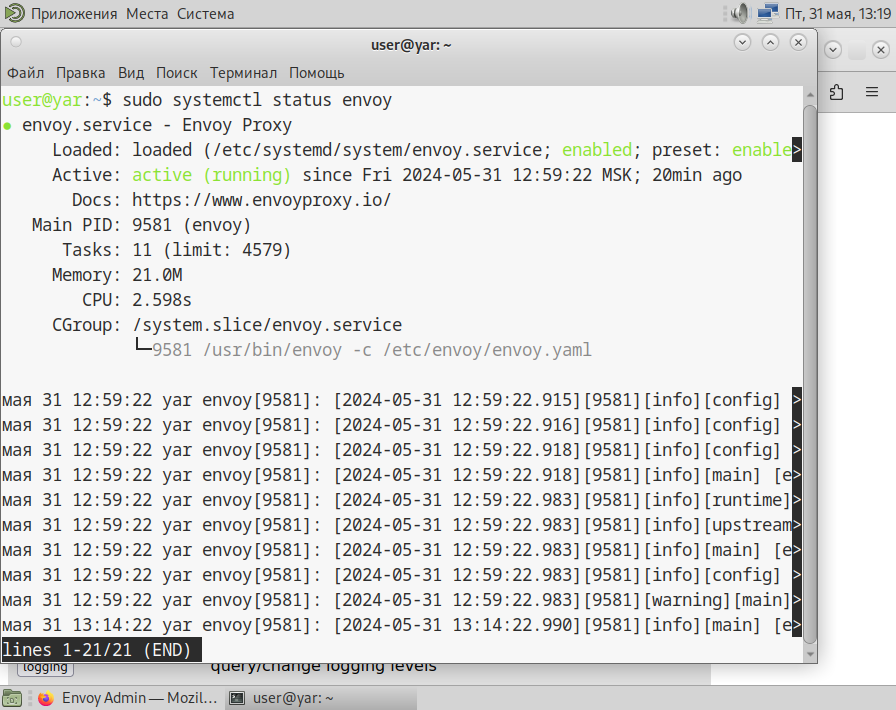

Анализ работы WSL

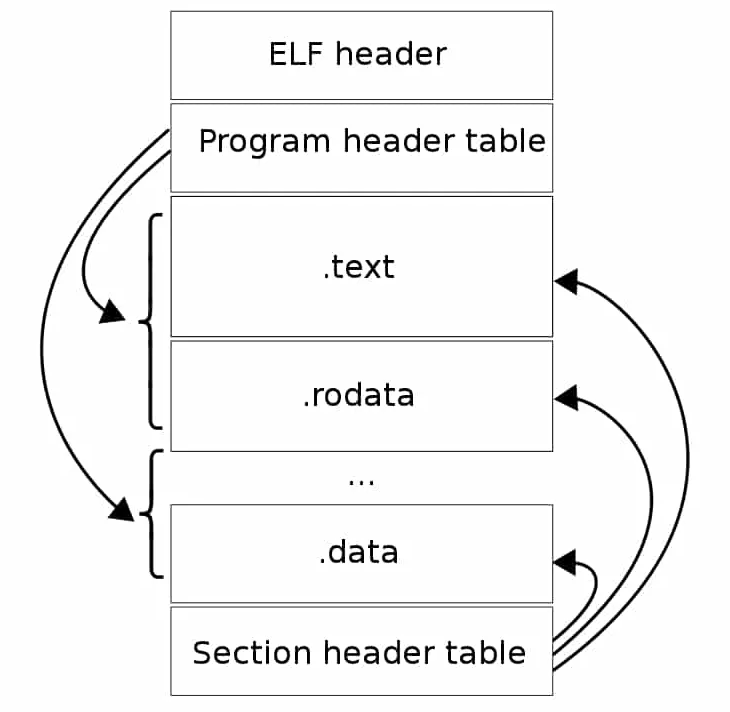

Работа WSL основана на нескольких ключевых компонентах:— Ядро Linux, которое является основой любой операционной системы Linux. Оно отвечает за взаимодействие с аппаратными средствами компьютера и выполнение большинства операций системы.

— Пользовательское пространство Linux, которое включает в себя все программы и утилиты, необходимые для работы в Linux. Это пространство включает в себя командную оболочку, файловую систему, сетевые утилиты и многое другое.

— Уровень совместимости, который преобразует вызовы API Windows в вызовы API Linux. Это позволяет приложениям Windows взаимодействовать с WSL без необходимости изменения кода.

Когда приложение Windows запускается в WSL, оно сначала проходит через уровень совместимости, который преобразует вызовы API Windows в вызовы API Linux. Затем приложение передаётся в пользовательское пространство Linux, где оно выполняется как обычное приложение Linux.

WSL также поддерживает установку дополнительных пакетов через менеджер пакетов APT или YUM, что позволяет расширять функциональность системы.